在HCIP數據庫服務規劃的學習中,數據處理服務是核心模塊之一,它涵蓋了數據從采集、處理到應用的完整生命周期管理。本文將圍繞數據處理服務的規劃要點展開,梳理關鍵概念、技術選型與設計原則。

一、數據處理服務概述

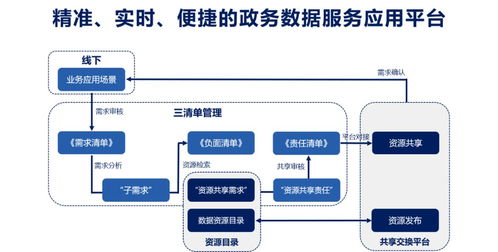

數據處理服務主要關注數據在系統內的流動與轉換,旨在將原始數據轉化為有價值的信息,支撐業務決策與應用。其核心流程通常包括數據抽取、清洗、轉換、加載(ETL)以及實時流處理等環節。在規劃時,需根據業務場景(如OLTP在線交易、OLAP分析或實時監控)確定處理模式,例如批量處理適合歷史數據分析,而流處理則適用于實時風控或推薦系統。

二、關鍵技術選型與規劃

- 數據存儲與計算框架:根據數據規模與處理需求,可選擇Hadoop生態(如HDFS存儲與MapReduce計算)處理海量離線數據,或使用Spark進行內存加速分析。對于實時場景,Flink或Storm等流處理框架更為合適。規劃時需評估集群資源、擴展性及運維成本。

- ETL工具與流程設計:常用工具如Apache NiFi、Kettle或云服務商提供的DataWorks。規劃重點在于設計高效的數據管道,包括數據源連接、去重、格式標準化等步驟,并確保數據質量與一致性。

- 實時數據處理架構:若業務需要低延遲響應,可采用Kafka作為消息隊列,配合流處理引擎實現實時計算。規劃時需考慮數據吞吐量、容錯機制(如檢查點設置)與端到端延遲指標。

三、數據處理服務規劃原則

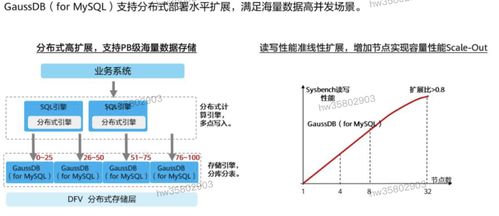

- 可擴展性:設計應支持水平擴展,以應對數據量增長。例如,采用微服務架構將處理模塊解耦,便于獨立擴容。

- 可靠性:通過冗余部署、故障轉移機制(如集群備份)保障服務連續性。對于關鍵數據流,需實施監控告警與自動恢復策略。

- 安全性:規劃中需集成數據加密、訪問控制(如RBAC角色權限管理)及審計日志,防止數據泄露或篡改。

- 成本優化:根據數據處理頻率與時效性,合理選擇資源類型(如按需實例或預留資源),并利用數據分層存儲(熱數據SSD、冷數據歸檔)降低開銷。

四、實踐案例與注意事項

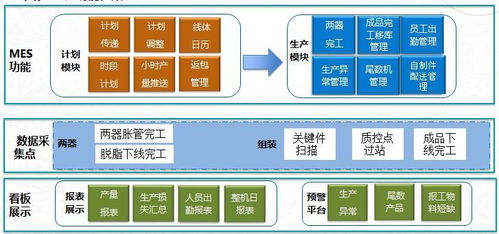

以電商場景為例,數據處理服務可能包括:用戶行為日志的實時采集(通過Flume/Kafka)、訂單數據的批量ETL(每日同步至數據倉庫)、以及基于Flink的實時推薦計算。規劃時需注意:

- 明確業務指標(如處理延遲低于1秒),并以此設計架構。

- 進行性能壓測,驗證數據處理峰值承載力。

- 制定數據治理策略,包括元數據管理、血緣追蹤,便于問題排查與合規審計。

五、

數據處理服務是數據庫服務規劃的關鍵支柱,其設計需緊密貼合業務目標與技術生態。通過合理選型、遵循擴展與安全原則,并結合持續監控優化,可構建高效、穩定的數據處理體系,為上層應用提供堅實的數據支撐。在學習與實踐中,建議多參考行業案例,并注重動手搭建實驗環境以深化理解。